李海峰1, 郭旺1, 吳夢偉1, 彭程里1, 朱慶2, 劉瑜3, 陶超1

1.

2.

3.

摘要

當前遙感智能解譯主要依賴視覺模型在遙感影像與語義標簽之間建立映射關系,但受限于有限類別的語義標注,模型難以學習地物及其關系的深層語義,進而無法涌現對世界知識的理解能力。隨著大語言模型的興起,依托其對語言中蘊含的人類知識的強大編碼能力,有望突破遙感視覺模型知識獲取的局限。通過大語言模型引導視覺模型,可顯著拓展其知識學習范圍,推動遙感智能解譯從語義匹配向世界知識理解躍遷。本文認為,視覺-語言聯(lián)合的多模態(tài)遙感解譯模型將引發(fā)新一輪范式變革。在此基礎上,本文進一步圍繞遙感地物概念表達展開系統(tǒng)分析。通過深入分析遙感地物的概念內涵與外延,揭示了單純依賴視覺模態(tài)在表達復雜遙感地物特征方面的不足,剖析了聯(lián)合視覺-語言兩種模態(tài)數據進行遙感地物概念表達的價值和意義。在此基礎上,詳細分析了遙感地物概念表達范式背后所面臨的模態(tài)對齊問題及其代表性解決方法,探討了該范式如何催化遙感解譯模型新能力的涌現,并對該能力的產生原因和實際應用價值進行分析。最后,本文總結并討論了在這種遙感地物概念表達框架下遙感影像智能解譯領域所面臨的機遇與挑戰(zhàn)。

關鍵詞

基金項目

湖南省杰出青年基金(2022JJ10072); 國家自然科學基金(42471419;42171376;41771458)

作者簡介

第一作者:李海峰(1980—),男,博士,教授,研究方向為多模態(tài)時空通用大模型、多模態(tài)時空信息記憶模型。E-mail:

通信作者:陶超 E-mail:kingtaochao@csu.edu.cn

本文引用格式

李海峰, 郭旺, 吳夢偉, 彭程里, 朱慶, 劉瑜, 陶超.

LI Haifeng, GUO Wang, WU Mengwei, PENG Chengli, ZHU Qing, LIU Yu, TAO Chao.

閱讀全文

http://xb.chinasmp.com/article/2025/1001-1595/1001-1595-2025-05-0853.shtml

理解遙感影像中所捕獲的地物概念及相互關系是遙感影像智能解譯的主要目標。傳統(tǒng)遙感智能解譯方法以視覺模型為基礎,利用模型自動提取遙感影像中地物的視覺特征[1],并通過建立視覺特征與地物標簽之間的映射關系描述地物概念,進而完成場景理解[2]、地物分類[3-4]、目標檢測[5-6]等多種遙感影像理解任務。然而現有的視覺模型在學習地物間復雜概念關系方面存在局限[7-8],這在處理背景復雜和環(huán)境動態(tài)變化的遙感影像時尤為明顯,導致模型的識別和分類性能受到限制。特別是在識別視覺上相似但功能或屬性有所不同的地物時,這些模型往往難以捕捉它們之間的細微差異。以細粒度耕地分類為例,不同耕地在視覺上僅存在細微差別,如顏色或紋理,但實際上它們的作物種類和耕作方式大不相同。如一個耕地可能主要種植水稻,另一個類似的區(qū)域卻用于種植小麥。傳統(tǒng)視覺模型在缺乏深入理解這些差異的情況下,可能無法準確區(qū)分這些耕地類型。因此,增強視覺模型對復雜遙感概念的理解能力,提升概念和概念關系的理解粒度,對于提高遙感影像解釋的精確度和可信度至關重要。

人類常用語言來表達和理解地物概念及其相互關系。如當觀察一張城市風光照片時,人們可能會評論:“這張照片中,我們可以看到一座現代化的大橋橫跨在寬闊的河流上,連接著兩岸的商業(yè)區(qū)。河流的這一側是一個繁忙的港口,裝滿了貨船和集裝箱,而對岸則是一片高樓林立的商業(yè)中心。”通過這樣的描述,人們不僅能夠理解照片中呈現的具體地物,如大橋、河流、港口和商業(yè)中心,還能夠把握它們之間的空間關系和相互作用,如大橋作為連接兩岸的重要交通樞紐,港口的經濟活動對商業(yè)中心的支持作用等。這種通過語言描述來輔助圖像理解的過程,使得人們能夠更加深入和全面地把握圖像所代表的場景和含義,開啟了圖像理解范式從傳統(tǒng)僅使用視覺模型到使用視覺-語言聯(lián)合表征模型的轉變。這一轉變在計算機視覺領域已經發(fā)生,一系列突破性的視覺-語言預訓練模型[9-10]的出現,如CLIP[11]、GPT-4V[12]和Flamingo[13]等,標志著這一領域的重大進展。同時,大量的圖文數據集的出現進一步推動了視覺-語言預訓練模型的邊界。這些圖文數據集,如COCO[14]、Visual Genom[15]和LAION[16]等,提供了豐富的視覺內容和對應的自然語言描述,為視覺-語言模型訓練提供了必要的數據基礎。

從2023年開始,遙感領域對從傳統(tǒng)視覺模型過渡到視覺-語言模型范式的轉變給予了極大關注[17],新的多模態(tài)模型框架研究如AllSpark[18]已經開始探索依靠語言模態(tài)統(tǒng)一多種模態(tài)數據的可行性。文獻[19—21]梳理了視覺-語言遙感智能解譯模型的應用現狀,并跟蹤了這些模型在遙感圖像描述任務上的快速發(fā)展。然而,在建立視覺-語言聯(lián)合空間表達遙感地物概念的意義、如何能夠提升遙感影像智能解譯效果,以及如何促進現有遙感解譯任務的發(fā)展等方面,仍缺乏深入的探討和分析。因此,本文致力于彌補這一空缺,通過深入分析遙感地物概念中的本體與實體,探討僅依賴單一模態(tài)(視覺或語言)表達遙感地物存在的局限性。在此基礎上進一步剖析構建面向遙感智能解譯的視覺-語言聯(lián)合空間的重要性及其基本理論方法。最后,探討為何視覺-語言聯(lián)合空間能夠促進遙感解譯模型性能的提升,并分析這種性能提升的可能條件。通過這一系列分析,旨在提供一個全面的視角,以理解視覺和語言模態(tài)融合對提升遙感影像解譯效果的潛力及其實現機制。本文的主要貢獻如下。

(1)本文以地物概念為起點,深入探討了視覺-語言模型在描述地物概念中的作用,并建立了一個綜合的概念描述框架。本文認為語言模態(tài)擅長負責闡釋地物概念的本體屬性和關系,而視覺模態(tài)擅長界定這些概念的具體實體。因此,在視覺-語言聯(lián)合的地物概念表達空間內,語言模態(tài)扮演著構建地物本體間相互關系的角色,而視覺模態(tài)則具體化語言描述的地物實體,由此確立了一個清晰的框架來理解和描繪遙感地物概念及其相互復雜關系。

(2)本文通過對現有語言與視覺模型中概念表達方式的分析,闡釋了構建視覺-語言聯(lián)合地物概念表達空間的重要性,并探討了面臨的主要挑戰(zhàn)——模態(tài)對齊問題。本文對現有對齊技術進行了分類,區(qū)分為顯式對齊和隱式對齊兩種策略,并討論了各自的優(yōu)勢與限制。

(3)本文探討了在視覺-語言聯(lián)合地物概念表達空間中,視覺和語言模態(tài)如何互為補充,進而催生了兩種創(chuàng)新的能力:一是通過概念組合泛化涌現的開放環(huán)境下未知目標識別辨別能力;二是通過繼承了語言模態(tài)表達的地物概念關系表現出的解譯模型生成預測能力。本文深入探討了這兩種能力產生的原因,并綜述了相關研究進展。

(4)本文總結并討論了構建視覺-語言聯(lián)合的地物概念表達空間為遙感影像智能解譯領域帶來的機遇與挑戰(zhàn),同時提出了潛在的研究方向,包括未被先前綜述所覆蓋的方向。

本文整體組織結構如圖1所示。

圖1 本文的整體組織結構

Fig. 1 Overall organizational structure of this paper

1 遙感地物概念空間

認識地物概念是遙感影像智能解譯的基礎。遙感影像本質上是在特定時空條件下對物理世界中的地物實體進行數字化采樣,而解譯性能則取決于模型對地物本身特性的認知能力[22-23]。因此,本文首先構建了一個由地物本體和地物實體組成的遙感地物概念空間框架,作為理解和解譯遙感地物的基礎。在這一基礎上,探討了地物本體和實體在認識地物概念中扮演的角色,并分析了單獨在視覺模態(tài)下或語言模態(tài)下表達遙感地物概念存在的不足,以此揭示利用單一模態(tài)解譯遙感影像的固有限制。

1.1 遙感地物概念空間的定義

在遙感影像智能解譯領域,影像本質上是在特定時空條件下對地物實體的數字化采樣,而解譯目標則是在影像中識別這些地物實體,并理解其所對應的地物本體[24-25]。基于這一認識,本文將遙感地物概念空間定義為一個結構化的知識圖譜(圖2),由地物本體和地物實體兩部分組成。然后通過地物本體和地物實體構建遙感地物概念空間理論框架,用于深入理解、認識和描述遙感地物。

圖2 遙感地物概念空間組成及相互關系

Fig. 2 Composition and interrelationships of the conceptual space for remote sensing geo-objects

(1)遙感地物概念空間組成:遙感地物概念空間由地物本體和地物實體兩部分組成,如圖2所示,不同節(jié)點代表各種地物本體,如林地、水稻田和耕地等,它們的外延是地物實體。在遙感地物概念空間中,本體和實體通過關系相連接。

(2)地物本體的定義與內涵:地物本體是對地物實體的概念化表達,這一表達通過本體屬性和本體關系共同實現。本體屬性定義了地物的基本特征,如:地物類別,基于地物實體的特征和屬性,對其進行分類和歸類的標準;地物功能,描述地物的用途和作用;結構特性,概括同類地物實體所共有的結構特點;生態(tài)特性,揭示地物與其所處生態(tài)系統(tǒng)之間的相互作用和依存關系。本體關系則刻畫了地物本體之間的相互作用和邏輯聯(lián)系,包括:語義關系,基于共享的屬性或功能,描述地物本體之間的相似性或同一性;組成關系,表明某一地物本體是如何由其他地物構成的;作用關系,反映地物本體之間的功能性影響,描述它們如何相互作用以實現特定的生態(tài)功能。

(3)地物實體的定義與內涵:地物實體代表地物在物理世界中的具體存在形式,通常通過實體屬性和實體關系進行描述。實體屬性反映地物在遙感影像中的可觀測特性,包括:光譜特性,描述地物在不同波長光譜中的反射或吸收特性;幾何特性,刻畫地物的形狀、大小及空間布局;紋理特性,體現地物表面的視覺和結構特征;時序變化,描述上述特性隨時間的動態(tài)變化情況。實體關系揭示地物實體在空間和時間上的聯(lián)系,主要包括:空間關系,描述地物實體在地理空間中的相對位置關系;時間關系,反映地物實體隨時間的變化及其演化趨勢。

1.2 視覺模態(tài)下的遙感地物概念空間表達

在遙感地物概念空間中,地物實體是具體的、可觀測的。通過無人機、衛(wèi)星或其他視覺傳感器采集的遙感影像,能夠詳盡地提供地物實體的形狀、顏色、紋理和光譜特性等信息。因此,遙感影像作為視覺模態(tài)數據,在描述地物實體方面具有顯著優(yōu)勢,具體體現如下。

(1)視覺模態(tài)的感知性:視覺模態(tài)能高效感知地物實體,通過遙感影像的像素反映地物實體屬性和實體關系。如春天的耕地在遙感影像中表現出規(guī)則的地塊形狀和網格狀的紋理,其地表農作物呈現碧綠的顏色。

(2)視覺模態(tài)的解析性:視覺解析性指通過視覺感知信息對地物類別進行推斷的能力。視覺模態(tài)能夠捕捉地物實體的視覺特征,通過特征的差異實現對地物實體精細的識別和分類。如在影像中,耕地和水體在光譜特性、幾何形態(tài)和紋理特征上存在顯著差異。

以視覺模態(tài)為中心的遙感影像智能解譯模型,通過視覺影像描述的地物實體信息與通過“類別標簽”描述的地物本體類別構建關聯(lián)。但這種關系通常是不完備的,因為地物本體屬性涉及更抽象的地物功能、結構特性或生態(tài)特性,而這些特性無法通過視覺捕捉,也難以通過“類別標簽”表達。因此,在表達地物概念時,雖然視覺模態(tài)下的遙感影像能捕獲并表達地物實體及實體關系,并將其映射至地物類別,但難以解析出地物本體關系中包含的語義關系、作用關系或組成關系。

1.3 語言模態(tài)下的遙感地物概念空間表達

地物本體是抽象的、不可觀測的。相對于視覺模態(tài),語言模態(tài)尤其擅長捕捉和表達地物本體的屬性和關系,不僅能夠直接描述抽象的地物類別、功能、結構特性和生態(tài)特性,還能基于這些特性推斷地物本體間的語義關系、組成關系和作用關系。這種特性由語言模態(tài)的描述性和邏輯性所支撐。

(1)語言模態(tài)的描述性:語言能夠詳細描述地物本體屬性,其特性能通過語句的組合直接表達。如在“城市公園不僅為城市提供了綠地,改善了空氣質量,還通過豐富的植被和水體調節(jié)了城市氣候”這句話中,城市公園的地物功能和生態(tài)特性得到明確的描述。

(2)語言模態(tài)的邏輯性:語言的邏輯性指基于語言描述可以進行邏輯推理。在遙感數據處理中,語言模態(tài)的邏輯性體現為通過邏輯推理來解釋復雜的地物關系,如“如果在連續(xù)的遙感圖像中觀察到城市公園內的綠地面積逐年增加,同時周邊的居民區(qū)也在擴展,那么可以推斷該城市公園不僅在生態(tài)保護方面發(fā)揮了重要作用,還可能提升了周邊區(qū)域的居住吸引力和生活質量”。

盡管語言模態(tài)在描述遙感地物本體的屬性和關系方面表現出良好的性質,但它缺乏對地物實體屬性及實體關系的表達能力。如語言可以描述一個地區(qū)的“城市綠化率高”,但無法直觀展現城市公園在影像中的光譜特性、幾何形狀和空間布局等視覺細節(jié)。這種局限使得語言模態(tài)表達的地物概念不如視覺模態(tài)直觀和精確。

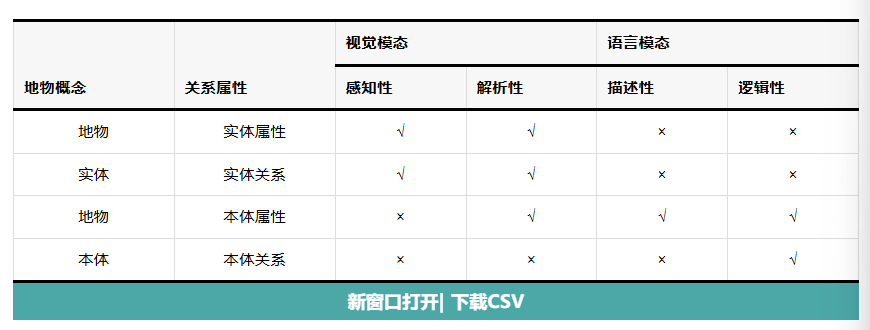

綜上,視覺模態(tài)和語言模態(tài)在描述地物概念上各有側重(表1)。視覺模態(tài)擅于描述地物實體,能夠通過視覺解析性推測本體類別,但難以捕捉或描述地物本體關系;語言模態(tài)擅長描述地物本體,卻難以細致表達地物本體外延的地物實體。兩種模態(tài)各有優(yōu)勢,在描述地物概念上存在較強互補性。

表1 視覺模態(tài)與語言模態(tài)對地物實體及地物本體表達

Tab. 1

2 遙感視覺-語言聯(lián)合地物概念表達空間構建

在遙感影像智能解譯領域中,語言模態(tài)擅長描述地物本體,而視覺模態(tài)則擅長直觀地表達地物實體。因此單獨使用語言或視覺模態(tài)來描述地物概念是不完備的。鑒于此,聯(lián)合視覺與語言模態(tài),構建一個視覺-語言聯(lián)合地物概念表達空間(圖3),使用語言描述地物本體,視覺描述地物實體,使兩種模態(tài)在地物概念表達空間中互補融合,從而實現對地物概念準確且完整的表達。本節(jié)將詳細討論在遙感影像智能解譯模型中構建視覺-語言聯(lián)合地物概念表達空間的意義及其面臨的挑戰(zhàn)。

圖3 視覺-語言聯(lián)合地物概念表達空間下的地物概念描述

Fig. 3 Geo-object concept description within the unified visual-language conceptual space

2.1 視覺-語言聯(lián)合地物概念表達空間構建的意義

目前遙感影像智能解譯領域主要依賴視覺模型,通過建立視覺特征與標簽之間的映射關系,為地物分類、分割、目標檢測和變化檢測等解譯任務提供了強大支持。然而,視覺模型僅建立了實體屬性特征與地物類別的靜態(tài)映射關系,并未真正“理解”影像,具體表現在兩個方面。①缺乏語義理解能力:視覺模型主要依賴像素級特征進行分類,而缺乏對地物本體屬性的理解,如模型可以識別出綠色區(qū)域為公園,但不能理解公園在城市生態(tài)系統(tǒng)中的重要作用。②缺乏復雜關系推理能力:視覺模型難以推理地物本體間的復雜關系。模型可以檢測到城市公園的存在,但難以推斷城市公園與城市園林和水體之間的語義關系和作用關系。

語義理解能力的缺失導致模型難以分辨視覺特征相似的影像所代表的不同語義。已有的基于知識圖譜的遙感影像智能解譯方法,通過視覺-語言聯(lián)合表達地物概念,顯著提升了模型的語義理解能力[26-27]。然而,這些方法主要依賴預先定義的地理專家知識所構成的結構化知識單元進行推理,如知識三元組[28]。在推理復雜地物本體關系時,盡管能提供有效的推理路徑,但相比于直接利用語言邏輯性進行推理,其動態(tài)性和準確性不足,難以適應并揭示時空變化背景下的復雜地物關系,從而導致模型在應對動態(tài)環(huán)境時表現不佳。因此,利用語言的邏輯性來增強模型對復雜關系的推理能力,并構建聯(lián)合地物概念表達空間,是提升遙感影像智能解譯模型地物理解能力的關鍵路徑。然而,由于視覺和語言模態(tài)在表達地物特征時各具特點與局限性,如何有效對齊二者以形成一致的地物概念表征,成為視覺-語言聯(lián)合地物概念表達的核心挑戰(zhàn)。

2.2 遙感視覺-語言模態(tài)的對齊

2.2.1 遙感視覺-語言模態(tài)對齊的意義

視覺-語言模態(tài)的對齊是構建聯(lián)合地物概念表達空間的基礎,實現視覺模態(tài)和語言模態(tài)的一致表達是消除視覺歧義、描述復雜地物本體關系、實現地物概念層面組合泛化的關鍵。在計算機視覺和自然語言處理領域,研究人員很早就認識到了將視覺與語言相結合的巨大潛力,并進行了初步的探索[29-30]。盡管這些早期工作為跨模態(tài)研究奠定了基礎,但他們并未充分挖掘語言模態(tài)的潛力,這一局面隨著CLIP[11]等突破性的工作的出現而得以改變。這類工作將自然語言作為監(jiān)督信號,充分利用了語言模態(tài)的特有優(yōu)勢,開啟了視覺-語言模型研究的新篇章。而在遙感領域,視覺-語言模型的應用也取得顯著進展,并且不斷有新的研究成果涌現。在遙感視覺-語言模型中,對齊(alignment)是實現視覺和語言結合的關鍵過程。通過對齊,遙感圖像中的視覺采集的實體屬性與語言表達的本體屬性相互關聯(lián),這不僅增強了地物概念的豐富性和精確性,還充分利用了語言在描述復雜、動態(tài)的物理世界中概念本體的獨特優(yōu)勢,推動模型對遙感圖像的深層次理解。

(1)消除視覺歧義:在理解遙感影像時,視覺雖然能夠傳達更豐富的信息,但受視角、環(huán)境條件、遮擋、陰影及對象多樣性等因素影響,不同觀察者可能對同一視覺信息產生不同的解讀,而語言可以提供關鍵的上下文信息,有助于消除視覺表征中的歧義。以圖4為例,由于不同本體屬性的遙感影像可能具有相似的視覺特征,僅依賴視覺模態(tài)推斷地物類別存在誤判的風險。然而,當視覺信息與相關的語言描述相結合時,語言表達的地物屬性和作用關系信息能夠幫助模型確認圖示土地是耕地而非荒地,從而有效消除視覺信息中的歧義。

圖4 視覺影像相似地物存在不同地物本體屬性情況

Fig. 4 Different geo-concept attributes for visually similar geo-entities

(2)描述復雜地物本體關系:語言在描述地物本體關系方面具有獨特優(yōu)勢,這是單純依賴視覺難以實現的。盡管計算機視覺在圖像分類、目標檢測等任務上取得了顯著進展,但這些技術主要關注學習地物實體的獨立視覺特征及其相互間的視覺差異,而非地物的本體屬性或本體關系。以圖4中左側影像為例,傳統(tǒng)的計算機視覺方法能夠準確將該圖分類為耕地,但其無法理解這張圖像其實是“耕地”與“春季”綜合作用的結果。借由語言,解譯過程可以突破時空的束縛,理解物候、地區(qū)和結構特性與“耕地”影像之間的作用關系。因此,語言不僅是信息的載體,更是理解和揭示地物本體關系的關鍵工具。語言與視覺的結合,是提升模型對復雜場景理解能力的必要手段。

(3)實現地物概念的組合泛化:語言和視覺的對齊為模型提供了實現地物概念組合泛化的基礎。現實世界中概念的組合是無窮無盡的,而人類之所以能夠進行高效復雜的認知與推理,很大程度上依賴于出色的概念解耦(將某種概念分解為若干子概念)和組合推理(將若干子概念組合以形成新概念)能力。語言作為人類表達和傳遞信息的主要媒介,天然具備這兩種能力。如前所述,借助于語言,遙感影像解譯模型能夠理解圖4中左側影像是“耕地”與春季物候綜合作用的結果,并且能夠在未見過冬季耕地影像的情況下,通過對語義的推理生成冬季的耕地影像。可見,語言的加入能夠引導模型建立語義推理能力,使其在應對復雜多樣的現實情境時,展現出更靈活、準確的組合泛化能力。

2.2.2 遙感視覺-語言模態(tài)對齊方法

盡管近年來在計算機視覺領域已開展大量視覺-語言對齊相關的研究工作,但這些研究往往基于一個假設:不同模態(tài)數據的收集成本相同,并且它們之間具有容易獲得的對應關系(如互聯(lián)網爬蟲獲取的圖像-文本數據對[31],視頻數據中同時存在的圖像-文本-聲音數據對[32])。然而,這一假設在遙感領域往往不成立,實際可用的遙感視覺-語言對齊數據十分有限,因此亟須一種不依賴于配對數據的對齊方法。近期的LAMP[33]、LM4VisualEncoding[34]等工作使用未預先定義配對關系視覺-語言數據就能達到模態(tài)對齊效果,這表明語言模態(tài)和視覺模態(tài)之間可能存在一種更為深層的隱式對齊關系。基于這一觀點,本文將現有的模態(tài)對齊研究劃分為顯式對齊和隱式對齊兩類,并討論了這兩類工作的價值和意義,內容組織如圖5所示。

圖5 遙感視覺-語言模態(tài)對齊現有研究工作組織結構

Fig. 5 Overall organizational structure of the remote sensing visual language alignment

(1)顯式對齊。為有效實現視覺與語言的模態(tài)對齊,一種直觀的方法是利用具有預先定義的視覺-語言對應關系(如圖像文本配對數據集)來訓練模型。在這種訓練框架下,模型通過學習圖像與文本之間的配對關系,本質上達成了模態(tài)間的對齊。以現有方法中圖像與文本對齊粒度的差異作為分類依據,本文將當前主流的視覺語言模型對齊相關工作分為3類:基于圖像-描述(image-caption)、區(qū)域-短語(region-Phrase)和圖像-指令(image-instruction)的對齊(圖6)。

圖6 顯式對齊方法

Fig. 6 The explicit alignment method

基于圖像-描述的對齊:在基于圖像-描述的對齊方法重點關注如何將圖像整體與其相應的文本描述進行對齊,旨在讓模型學習圖像內容與文本描述之間的關聯(lián)性。CLIP[11]是這類方法的代表工作之一,通過對比學習構建圖像與文本的聯(lián)合表征空間,并激發(fā)了一系列改進性工作,如UniCL[35]、KLITE[36]和LaCLIP[37]。鑒于對比學習的任務無關特性,這類方法適合作為視覺-語言基礎模型,可通過微調、少樣本甚至零樣本學習迅速適應各種下游任務。然而,這類方法依賴于大量高質量的圖文配對數據,且難以兼顧圖像理解和文本生成任務。為此,SimVLM[10]引入了PrefixLM預訓練任務來實現多任務兼容,BLIP[38]通過Cap Filt機制降低數據中的噪聲,顯著提升了模型對圖像和文本模態(tài)的理解能力。為了在遙感領域引入視覺語言模型,文獻[39]利用UCM Captions[40]數據集訓練并構建了遙感視覺語言模型。然而,該數據集規(guī)模較小且語義表達有限,制約了模型對復雜遙感場景的理解能力。隨著RSICD[41]、RSIT MD[42]等大規(guī)模多樣化數據集的出現,特別是RemoteCLIP[19]和GeoRSCLIP[43]構建的百萬級遙感圖文數據集,結合Transformer[44]架構的深度建模能力,顯著提升了模型對復雜遙感場景的解析能力。然而,基于圖像-描述的對齊方法仍普遍缺乏對圖像內容的深層次、細粒度理解。這一局限主要源于簡單的圖文配對數據無法提供足夠的引導信息,從而限制了模型在理解復雜視覺-語言關系方面的能力。

基于區(qū)域-短語的對齊:為增強模型對圖像的細粒度理解能力,一些研究開始探索將圖像區(qū)域與文本單詞或短語之間的深層次對應關系融入數據中。如ViLBert[45]通過外部目標檢測器識別感興趣區(qū)域,并運用RoIAlign[46]等技術提取特征,進而與相應文本單詞或短語進行匹配。然而,這種方法存在顯著缺陷:首先,依賴預訓練的外部檢測器限制了目標類別范圍,并直接影響模型性能;其次,附加的檢測模塊增加了模型的容量并降低了訓練效率。為此,VL-BERT[47]將檢測模塊整合進訓練過程中,ViLT[48]則徹底摒棄檢測模塊,直接采用Transformer[44]提取圖像特征,而背景模糊[49]、掩膜[50]和特征融合[51]等策略則緩解了僅提取局部特征導致的上下文信息丟失問題。文獻[52—53]發(fā)現這種對齊方式同樣能提升遙感視覺語言模型的解譯能力,它們利用編碼器-解碼器架構提取目標區(qū)域特征,但忽視了對空間結構信息的提取。為此,文獻[54]提出了結構化注意力機制,將高分辨率影像的語義拓撲關系融入區(qū)域-短語對齊。GeoVG[55]通過雙流網絡融合視覺特征與地理空間關系圖,實現更精確的視覺定位,而RSVG[56]進一步引入MGVLF模塊,強化顯著特征并抑制噪聲,大幅提升對齊精度。此外,在小樣本目標檢測任務中,TEMO[57]通過加入多類別語義描述有效緩解了類別歧義,揭示了跨模態(tài)先驗知識對細粒度理解的核心價值。這些研究表明,去除對外部檢測器的依賴、深度融合領域知識、優(yōu)化局部與全局特征平衡,是提升視覺-語言對齊效果的關鍵路徑。

基于圖像-指令的對齊:雖然前述的圖像-描述和區(qū)域-短語對齊方法能有效實現視覺與語言模態(tài)的直接對齊,然而在表達概念間的復雜抽象關系方面存在局限,制約了模型對地物概念的組合泛化能力。基于圖像-指令的對齊方法則顯現出其獨特價值,其核心思路在于通過豐富語言模態(tài)下的概念關系表達,引導模型在更精細的概念粒度下對齊視覺與語言模態(tài)。早期工作[58-59]基于CNN[60]、RNN[61]或LSTM[62]架構的圖像-指令對齊方法受限于特征提取能力,導致模型難以深度理解圖像和文本及其對齊關系,這一問題在遙感影像解譯領域也有所體現[63]。隨著Transformer[44]在NLP領域的突破,以及ChatGPT[64]展現出的通用知識理解與邏輯推理能力,視覺-語言多模態(tài)模型的語言理解能力得到了顯著提升[65-66]。文獻[67]通過在指令中加入遙感專家知識,構建了VQA-Text RS圖像-指令數據集,并提出了基于Transformer[44]架構的VQA模型,能夠深度理解遙感影像中的地物關系。LLaVA[68]和InstructCLIP[69]等框架能通過指令微調,精準把握圖像中的深層次概念關系。然而,盡管文本指令增強了模型的視覺理解能力,圖像與文本的對齊關系卻未得到充分保障。為此,CAT[70]在純文本指令的基礎上構建圖像-文本指令,以此引入模態(tài)對齊關系,而SEA L[71]通過視覺搜索機制,使模型能夠精準捕捉圖像關鍵區(qū)域及其復雜語義關聯(lián),從而進一步提升視覺理解能力。

綜上,從圖像-描述到區(qū)域-短語,再到當前熱門的圖像-指令對齊方式,隨著圖像-文本匹配粒度從粗到細的發(fā)展,遙感智能解譯技術在地物理解層次上逐步深化。具體而言:圖像-描述對齊方式主要針對整幅圖像與整體文本描述的匹配,屬于圖像文本均為粗粒度的對齊方式,這種方法側重于捕捉圖像的整體語義;區(qū)域-短語對齊方式則細化了圖像內容,將圖像劃分為多個區(qū)域,并與相應的短語進行匹配。這種方法中圖像為細粒度,但文本仍為粗粒度(對區(qū)域整體的描述),雖然能夠更精確地定位并描述圖像中的具體地物目標,但缺乏對地物目標間概念關聯(lián)的細致描述;圖像-指令對齊方式則進一步細化了圖像-文本的對齊粒度,通過復雜指令描述地物間的關聯(lián)關系,并引導模型關注影像中的多種地物目標。這種方法不僅能夠對齊影像中的多地物目標,還能通過豐富的語義指令表達地物目標間的關聯(lián)關系,深化解譯模型對遙感影像的理解層次。

(2)隱式對齊。盡管顯式對齊已成為構建視覺-語言模型的主流范式,但在實踐中仍面臨諸多挑戰(zhàn)。首先,顯式對齊依賴大規(guī)模圖文數據集,而構建高質量的圖文配對關系需要大量人力成本。其次,模態(tài)聯(lián)合訓練顯著增加了計算和時間開銷。雖然語言和視覺在概念表達上是異構的,但兩者本質上描述的是同一個物理世界,這一事實意味著無論視覺語言模態(tài)對齊關系是否被人為定義,兩者應當存在內在的統(tǒng)一收斂條件。文獻[72]驗證了不同架構、訓練目標的視覺模型在表征上存在高度的一致性,隨著模型規(guī)模和數據規(guī)模的增大繼續(xù)提升,這一規(guī)律在跨模態(tài)的視覺語言模型上同樣適用。無獨有偶,文獻[73]證明利用未進行對齊的視覺編碼器和語言編碼器也能完成字幕匹配或檢索任務,同樣佐證了視覺和語言表征空間存在內在的一致性。這進一步引出了一個根本性的疑問:語言和視覺之間是否存在一種內在的、未顯式定義的對齊關系?倘若如此,即使僅依賴單模態(tài)數據,也有可能實現視覺與語言之間的概念對齊,即真正意義上的隱式對齊。

視覺到語言空間的隱式對齊旨在深入探索視覺信息如何通過單模態(tài)的視覺數據對應到語言表征空間。在此研究領域中,LM4VisualEncoding[34]發(fā)現,即使僅在文本數據上進行訓練,大語言模型中的編碼器在純視覺任務和多模態(tài)任務上也能提取有效特征。此外,LAMP[33]則證實了預訓練的語言模型能直接識別三維點云數據的語義,進一步表明語言模型具備在非傳統(tǒng)文本數據理解處理中的廣泛適應性。隨著遙感及其相關技術的快速發(fā)展,每天都可以生產大量的遙感數據,然而想要構建遙感領域的大規(guī)模圖像-文本對數據仍然是十分困難的。因此,將隱式對齊引入遙感領域是十分必要的。最近也有一些工作沿該路線進行探索,如GRAFT[74]利用地面上拍攝的共同位置的互聯(lián)網圖像作為連接遙感圖像和語言的中介,提出了一種在不使用任何文本注釋的情況下訓練遙感視覺-語言模型的方法。這類嘗試在遙感領域引入隱式對齊的工作,為解決大規(guī)模圖像-文本對數據不足的問題提供了研究方向,但仍處在初級階段,需要未來進一步的探索。

3 視覺-語言聯(lián)合地物概念表達空間激發(fā)的遙感解譯模型的性能涌現

構建視覺-語言聯(lián)合地物概念表達空間面臨諸多挑戰(zhàn),但也帶來了巨大的機遇。在視覺-語言聯(lián)合地物概念表達空間中,語言模型和視覺模型的結合不僅彌補了各自的不足,還涌現出了兩類能力:通用辨別能力和生成預測能力(圖7)。通用辨別能力是指通過對地物概念的組合推理,視覺-語言模型能夠推斷未見影像的地物本體屬性;生成預測能力指通過關聯(lián)地物實體視覺特征和地物本體屬性,模型能夠利用語言模態(tài)的邏輯性推理出語言所描述地物本體的實際影像。下面將進一步討論這兩種能力產生的原理與其應用。

圖7 視覺-語言模型能力涌現

Fig. 7 Emergent abilities of vision-language model

3.1 遙感影像解譯模型通用辨別能力的涌現

3.1.1 通用辨別能力涌現的原理

視覺-語言模型通用辨別能力的涌現本質上是視覺模態(tài)感知性與語言模態(tài)邏輯性高效結合的結果。這種能力的形成源于視覺-語言聯(lián)合地物概念表達空間對視覺特征所關聯(lián)的地物本體間關系的推理。在聯(lián)合地物概念表達空間中,語言作為表達地物本體關系的媒介與視覺模態(tài)提供的地物實體屬性相結合,實現對未知地物概念本體屬性的推斷。這一過程中首先通過視覺模態(tài)描述影像中包含的地物實體屬性,并解析它們對應的地物本體,如圖7(a)所示,影像中地形特點、地塊形狀和地表特征被視覺模態(tài)感知,作為視覺嵌入被關聯(lián)至對應的地物本體,再借助語言模態(tài)的邏輯性,實現從“耕地+冬季”到“冬季耕地”的推理。

3.1.2 通用辨別能力的應用

通用辨別能力主要體現在零樣本識別任務中。在遙感影像智能解譯領域,零樣本識別任務的目的在于能夠準確識別和分類從未見過的地物類型,這對于應對快速變化的地理環(huán)境和探索未知區(qū)域至關重要。如面對一個未知型號的艦船影像,盡管模型沒有預先被訓練識別這種型號,但它可以通過分析已捕獲的視覺特征,如甲板結構、雷達位置及船艙布局等,推測出艦船的型號。在引入視覺-語言模型前,傳統(tǒng)的視覺模態(tài)在處理零樣本識別任務時面臨巨大挑戰(zhàn)。其核心問題在于視覺模型難以構建已知視覺表征和未知地物本體間的關聯(lián),無法有效地理解和組合新的地物概念。

引入視覺-語言模型后,語言模態(tài)的邏輯性為零樣本識別帶來了突破。語言模態(tài)不僅能夠描述地物的本體屬性和本體關系,還具備通過邏輯推理來重組和推廣地物本體的能力。這使得模型能夠在沒有目標地物本體直接視覺證據的情況下,通過已知實體屬性的地物類別來推斷未知地物本體。零樣本識別方法的核心在于將視覺特征與語言模態(tài)的詞向量相關聯(lián),以彌補視覺模態(tài)的局限性。在這種方法中,從語言模態(tài)數據中提取的詞向量空間用于量化不同地物本體之間的關系,從而通過對已知地物本體的邏輯推理,實現對未知地物實體的本體預測。現有零樣本識別工作可以按詞向量空間的特點分為兩類方法:①基于靜態(tài)詞向量模型;②基于動態(tài)詞向量模型。

(1)基于靜態(tài)詞向量空間的零樣本識別方法:靜態(tài)詞向量模型如Word2Vec[75]、GloVe[76]和Fast Text[77]等是一種通過將高維詞匯表征映射到低維空間,捕捉詞語的語義關系和內部結構的方法。基于這一詞向量空間,SAE[78]方法通過將視覺特征與知識圖譜及Word2Vec[75]詞向量相結合,構建了一個統(tǒng)一的概念空間,實現了圖像目標的零樣本識別。這種方法利用了知識圖譜的豐富語義和Word2Vec[75]的語言模型能力,以提升對未見類別的識別效果。在遙感領域,一些早期探索零樣本遙感影像場景識別的工作[79-80]基于SAE[78]方法,利用視覺模型從遙感影像中提取視覺表征,再將表征通過地理知識圖譜關聯(lián)到語義空間,最后利用靜態(tài)詞向量表征構建語義關系以推測未見地物本體屬性,實現對未知地物實體的零樣本識別。

(2)基于動態(tài)詞向量空間的零樣本識別方法:在開放場景上下文變化的動態(tài)語境中,ELMo[81]、Bert[82]和GPT[83]等語言模型通過引入深度神經網絡,能在上下文中動態(tài)地提取地物本體屬性及它們間的局部和全局關系。在此基礎上,視覺-語言模型如CLIP[11]及其改進方法A LGIN[84]和BLIP[38],通過在大規(guī)模視覺文本對上訓練多模態(tài)模型,有效地結合了視覺模型和這類語言模型。CLIP[11](圖8(a))不僅能夠捕捉遙感圖像的視覺細節(jié),還能理解和表達與這些圖像相關的地物本體。GeoRSCLIP[43]方法采用遙感視覺-語言數據集RS5M[43]訓練(圖8(b)),利用針對遙感影像的語言描述,使語料內容更加精細和專業(yè)化。通過微調CLIP[11]的視覺-語言聯(lián)合表征空間,GeoRSCLIP[43]顯著提升了遙感影像零樣本分類任務的精度。

圖8 零樣本識別方法及訓練數據集

Fig. 8 Zero-shot recognition method and training dataset

綜上所述,基于靜態(tài)詞向量空間的方法難以準確表示復雜環(huán)境下地物本體的動態(tài)變化。相比之下,基于動態(tài)詞向量空間的方法能夠根據上下文準確推斷地物本體屬性,但仍面臨視覺和語言概念表達粒度不一致的問題。隨著語言模態(tài)的引入,基于語言邏輯性的地物本體推理有效解決了面對未見地物實體或未知地物本體情況下的識別問題,然而模態(tài)間的錯誤對齊將直接影響視覺特征與地物本體的匹配精度,進而影響后續(xù)的推理。

3.2 遙感影像解譯模型生成預測能力的涌現

生成預測能力,本質上是一種基于語言描述的地物本體理解,生成地物實體影像的能力。這種能力不僅體現了對地物本體的深層次理解,還能夠刻畫出地物實體的精細視覺特征,幫助解譯模型更準確地理解和識別遙感影像中的地物,構建地物本體與地物實體的關聯(lián)。由此可見,在遙感影像智能解譯中,遙感影像生成任務具有重要意義。首先,生成影像能夠彌補實際影像采集中的時空局限性,提供額外的訓練數據,豐富模型的學習樣本,從而提升解譯性能。其次,生成影像還能有效克服噪聲數據對模型訓練的影響,通過增加高質量的樣本來提高模型的穩(wěn)健性。此外,通過生成影像,模型可以進一步驗證其對地物本體的理解,確保其在復雜環(huán)境中的解譯能力,增強模型在多變場景中的適應性和準確性。

3.2.1 生成預測能力涌現的原理

語言模型以其擅長的邏輯推理為基礎,能夠利用已知的語言描述信息精確推斷出所描述場景中的細致語義構成。然而,單獨依靠語言模態(tài)無法直接重建出與這些語義構成對應的具體影像,視覺模態(tài)的嵌入為語言模態(tài)提供了地物實體屬性信息的補充,這使得從語言描述到具體影像的轉化成為可能。如圖7(b)所示,在遙感影像解譯中,模型可以通過分析語言描述(如“生成一幅冬季的耕地遙感影像”)理解并預測出影像中將顯示的具體內容(如裸露的土地和地表上的積雪)。這不僅僅是簡單的圖像匹配,而是一種動態(tài)的、創(chuàng)造性的重建過程,依賴于對場景語義深層次的推理和視覺信息的細致解析。

3.2.2 生成預測能力的應用

生成預測能力主要應用于遙感影像生成任務中,這一任務極大地解決了目標地區(qū)觀測受限或無法觀測情況下數據難獲取的解譯難題。如在去云、去霧等任務中,傳統(tǒng)方法面對被云霧遮擋的區(qū)域時往往無法有效處理。然而,通過視覺-語言模型的生成預測能力,模型能夠基于已觀測到的視覺信息生成被云霧遮擋區(qū)域的潛在遙感影像。

遙感影像生成任務在引入語言模態(tài)前后產生了巨大的變化,引入視覺-語言模型前,遙感影像生成方法主要依賴擴散模型[85]技術,擴散模型是一種基于概率擴散過程的生成模型,首先通過引入噪聲逐步將數據x0“擴散”到一個隨機的狀態(tài)z,如圖9所示,然后再逐步學習如何從這種高噪聲狀態(tài)逆向恢復出清晰的圖像,模型在這一擴散過程中學習,關注如何從xt狀態(tài)恢復xt-1狀態(tài)的影像。這種方法在生成細節(jié)豐富且具有高質量的圖像方面表現出色。在遙感影像領域,利用擴散模型進行圖像生成的關鍵問題在于如何設計控制條件,以確保生成的影像能夠遵循遙感影像的特性。如DDRF[86]通過擴散過程實現遙感影像融合圖像的生成,將兩幅待拼接影像作為生成預期影像的強控制條件;DMDC[87]基于擴散模型進行超像素影像生成,利用低分辨率影像作為生成高分辨率影像的強控制條件。控制條件在這些應用中起到了至關重要的作用,確保了生成影像的準確性和穩(wěn)定性。然而,在弱化控制條件的情況下,擴散模型難以準確和穩(wěn)定地生成預期的遙感影像。缺乏強控制條件的引導,模型可能會在生成過程中偏離遙感影像的特性,導致生成結果與實際需求不符。

圖9 擴散模型擴散過程概念

Fig. 9 Diffusion process concept of diffusion model

引入語言模態(tài)后,語言的描述性為可控圖像生成帶來了突破。利用語言模態(tài),用戶可以通過自然語言描述指定生成影像的內容、細節(jié)和風格,從而實現更精細的控制和個性化的圖像輸出。遙感影像生成任務中語言描述作為控制條件允許研究人員和專業(yè)人士精確地定義所需觀察的地物本體,如特定類型的植被、土地利用情況或氣候條件,使得生成的圖像不僅在視覺上符合預期,而且在語義上與描述緊密對應。這類工作如RemoteDiffusion[88]、CRSDiff[89]和Diffusionsat[90],通過整合語言模型到擴散模型中,實現了更精細的可控遙感影像生成(圖10)。

圖10 語言描述及遙感影像生成結果示例

Fig. 10 Examples of text captions and remote sensing image generation results

得益于語言的描述性,這類方法有效解決了傳統(tǒng)圖像生成技術中生成影像可控性差和可解釋性差的問題。通過利用語言模態(tài)對地物本體的細致描述,這類技術能夠提供更加直觀和精確的控制方式,從而生成符合具體描述的高質量圖像。盡管如此,該技術目前仍然面臨圖像與文本對齊準確性的挑戰(zhàn),尤其是在處理復雜的語義或多義性強的文本描述時,模型通常難以生成預期影像。因此,如何在遙感影像生成過程中確保圖像內容與文本描述之間的高度一致性,以實現更精細的圖像內容控制,將是未來推動這一技術進步的核心任務。

4 視覺-語言聯(lián)合地物概念表征在遙感影像智能解譯中的應用

本文旨在探討視覺-語言聯(lián)合地物概念表征在遙感影像智能解譯中的應用,并通過試驗案例重點分析在場景分類、目標檢測、語義分割和影像生成4類任務中,視覺-語言聯(lián)合的解譯范式相較于傳統(tǒng)純視覺解譯范式的解譯性能差異,以展示視覺語言模型如何通過增強語義理解、提高識別準確性和擴展生成能力,顯著提升遙感影像智能解譯性能。

4.1 遙感影像場景分類

遙感影像場景識別任務是指對遙感影像中所呈現的整體場景進行自動分類和識別的過程。與目標檢測或語義分割任務不同,場景識別關注的是影像中較大范圍內的綜合特征,這些特征可能包括多個地物類型、不同的地理結構和復雜的環(huán)境元素。

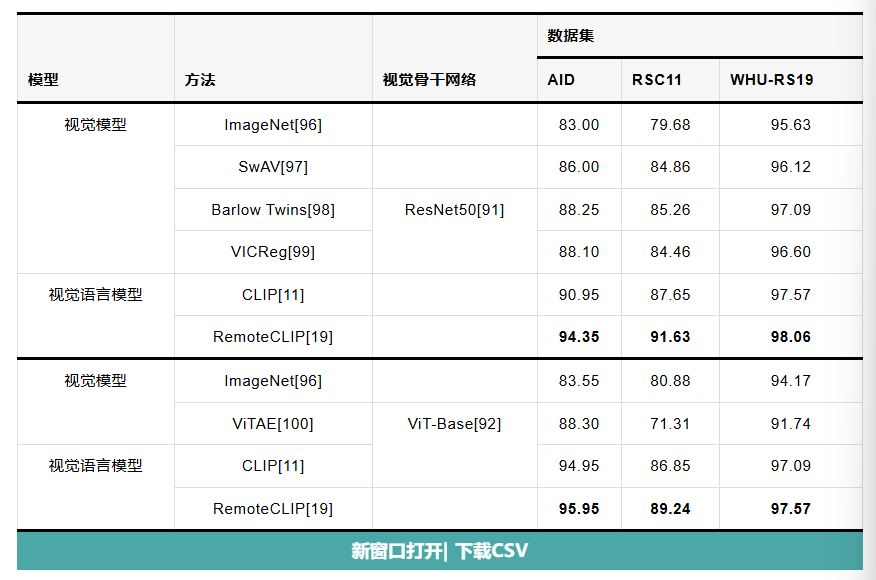

傳統(tǒng)視覺模型在學習多目標耦合的視覺特征與單一場景標簽的映射關系時,往往將場景類別與影像中的具體目標組合緊密關聯(lián)。這種強耦合的映射方式在目標組成發(fā)生變化時,模型難以適應,進而導致泛化性降低。視覺-語言模型的引入打破了這一困境,通過利用語言描述地物本體關系,模型能夠引導不同視覺目標特征與其對應的地物概念相關聯(lián),在復雜場景中根據影像中的地物概念推理場景類別。RemoteCLIP[19]在試驗中驗證了這一觀點,在采用相同的視覺編碼器骨干網絡(ResNet50[91]或ViT-Base[92])條件下,聯(lián)合視覺-語言的場景分類模型在不同場景數據集(AID[93]、RSC11[94]和WHU-RS19[95])上均取得優(yōu)于純視覺模型的平均分類精度(表2)。

表2 分類精度(OA)對比

Tab. 2

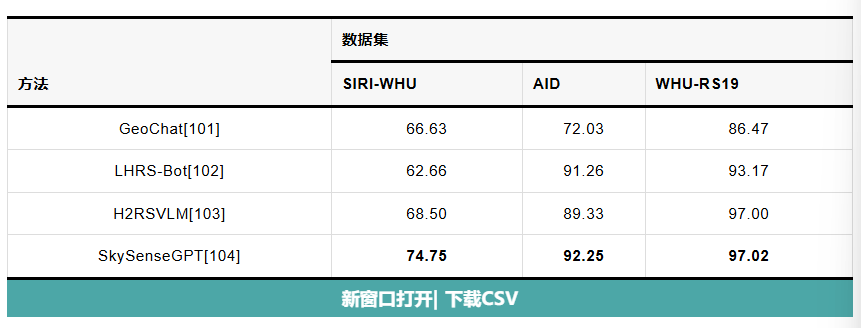

在任務場景存在新類別的情況下,視覺模型無法通過下游任務的微調來發(fā)揮其場景識別能力。相比之下,遙感視覺語言模型通用辨別能力的涌現,使得模型能夠依托已知地物概念及地物本體關系,在零樣本的情況下推理場景類別,顯著增強了解譯模型對不同解譯場景的適應性。近期的視覺語言遙感智能解譯模型,如GeoChat[101]、LHRS-Bot[102]、H2RSVLM[103]和SkySenseGPT[104],能夠在未見過的場景數據集SIRI-WHU[105]、AID[98]和WHU-RS19[100]下實現場景識別,且達到較高精度,試驗對比結果見表3。

表3 零樣本場景識別精度(OA)對比

Tab. 3

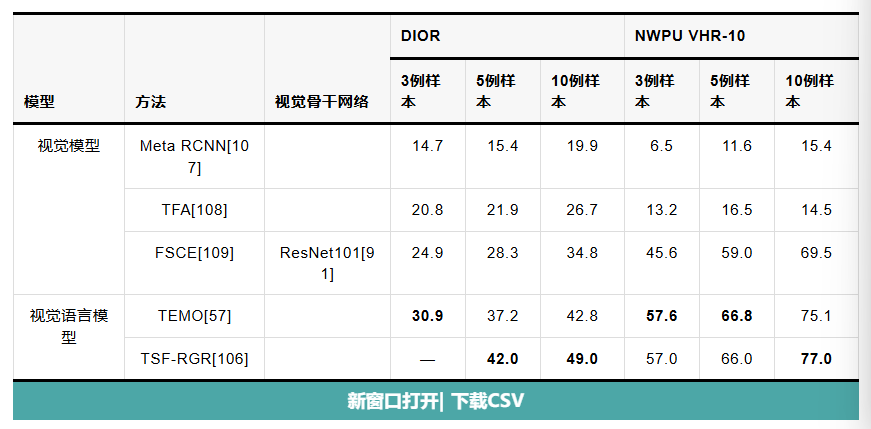

4.2 遙感影像目標檢測

目標檢測是遙感影像解譯領域中的一項核心任務,主要通過識別物體的邊界框和類別標簽來檢測目標實例。近年來,小樣本目標檢測在遙感影像中的應用逐漸成為一個備受關注的研究領域。這一任務的挑戰(zhàn)在于如何在僅有少量標注樣本的情況下,有效檢測遙感影像中的感興趣目標。隨著視覺語言模型的引入,遙感影像智能解譯模型在這一任務中展現出了顯著的性能提升。遙感視覺語言模型如TEMO[57]和TSF-RGR[106]依托語言模態(tài)中的地物本體關系,通過將視覺特征與語言描述進行深度融合,能夠更好地捕捉和理解復雜的地物語義結構。相比之下,純視覺模型如Meta RCNN[107]、TFA[108]和FSCE[109]主要依賴于視覺特征的匹配,在應對復雜多變的遙感場景時存在一定局限性。表4反映了上述視覺模型和視覺-語言模型基于相同視覺骨干網絡(ResNet101[91]),在遙感影像目標檢測數據集DIOR[110]和NWPU VHR-10[111]等數據集上的試驗結果,通過對比mAP可以觀察到視覺-語言模型在少樣本條件下的目標檢測精度優(yōu)于純視覺模型。

表4 小樣本目標檢測性能對比(mAP)

Tab. 4

4.3 遙感影像語義分割

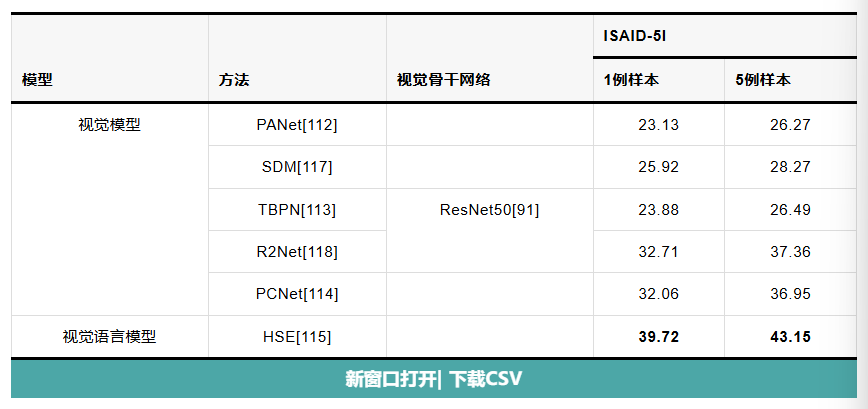

遙感影像語義分割是遙感影像智能解譯領域中的一項基礎任務。與目標檢測任務僅需識別地物的類別與位置不同,語義分割任務進一步要求準確識別地物類別及其在影像中占據的具體像素區(qū)域。這通常依賴于基于視覺模型的監(jiān)督學習方法,利用高質量的像素級標簽來學習地物語義與像素區(qū)域間的映射關系。然而,由于遙感影像中地物目標的復雜多樣性,高質量的語義分割標簽獲取困難,這使得傳統(tǒng)的監(jiān)督學習方法在沒有充分標注數據的情況下效果受限。為了降低模型對大量高質量標注數據的依賴,小樣本語義分割問題近年來備受關注。基于視覺模態(tài)的小樣本學習方法,如PANet[112]、TBPN[113]和PCNet[114]等,通過從少量樣本中提取原型(prototype)特征,并與影像中的視覺特征進行匹配來實現語義分割。這些方法在目標場景與訓練樣本的視覺表現較為一致時表現良好。然而,當面臨視覺表現差異較大的新場景時,這些方法往往難以有效分割。在這一領域的最新發(fā)展中,HSE[115]模型通過引入語言模態(tài),在利用視覺模型提取地物的原型特征基礎上,將這些特征與通過語言模態(tài)表達的地物概念相關聯(lián)。通過這種方式,地物的原型特征不再是孤立的,而是與其語義描述緊密連接,使得模型能夠利用豐富的語言信息來增強視覺特征的泛化能力。在ISAID-5I[116]數據集上的試驗結果見表5。

表5 小樣本語義分割性能對比(mIoU)

Tab. 5

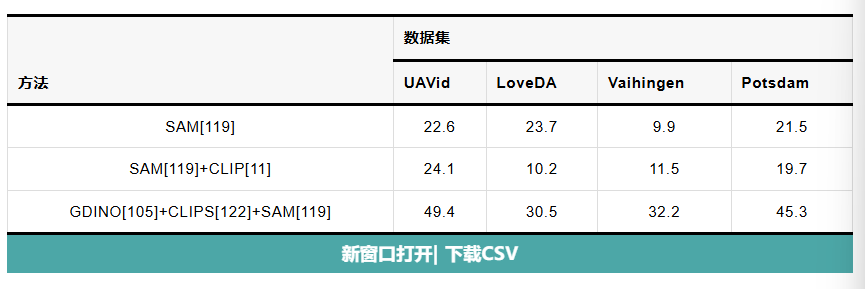

在零樣本語義分割方面,隨著視覺-語言模型和視覺基礎模型的發(fā)展,計算機視覺領域相關工作如SAM[119]、GDINO[120]和CLIP[11]在探索零樣本語義分割和零樣本分類問題上取得突破進展。然而,視覺基礎模型能提取單一語義在影像中的像素區(qū)域,卻難以判斷其語義的具體類別;視覺-語言模型能夠判斷影像類別,但難以分辨這一類別所占據的具體像素區(qū)域。能否通過關聯(lián)這兩類模型,實現遙感影像地物概念的深度表達,以嘗試在零樣本情況下對遙感影像進行語義分割呢?Text2Seg[121]做出了相關嘗試,通過組合GDINO[120]、CLIPS[122]和SAM[119],在UAVid[123]、LoveDA[124]、Vaihingen[125]和Potsdam[125]數據集上驗證零樣本下的遙感影像語義分割效果。表6展示了不同組合下的分割性能。

表6 零樣本遙感影像語義分割性能(mIoU)

Tab. 6

4.4 遙感影像生成任務

遙感影像生成在遙感影像智能解譯中發(fā)揮著至關重要的作用。首先,遙感影像生成技術能夠為深度學習模型的訓練提供豐富的樣本數據,特別是在數據稀缺或獲取成本高的情況下,通過生成高質量的模擬遙感影像,顯著增強模型的泛化能力和穩(wěn)健性。其次,遙感影像生成技術還可以用于數據增強,通過生成多樣化的影像樣本,提升模型在不同場景和條件下的表現,增強其對不同地物特征的識別能力。如RemoteDiffusion[88]、CRS-Diff[89]和Diffusion-SAT[90]等,通過語言模態(tài)的描述性引導模型精確生成所需的影像;類似地,MetaEarth[126]實現了全球尺度的遙感影像生成,極大地擴充了高質量遙感影像樣本庫,試驗中利用該方法生成5倍數量于預訓練遙感數據的擴充數據訓練骨干網絡,如VGG[127]、ResNet[91]和ViT[92],并在下游任務適配中觀察模型識別精度得到了有效提升(表7)。

表7 場景識別精度(OA)對比

Tab. 7

5 未來研究方向

5.1 視覺-語言聯(lián)合地物概念表達空間下的多模態(tài)遙感數據聯(lián)系與對齊

多模態(tài)遙感數據(如光學、紅外、高光譜、SAR、LiDAR等)能夠反映地物不同特征,如能有效利用,將發(fā)揮“1+1>2”的效果。然而,不同模態(tài)數據因其內在機理(如空間分辨率和光譜特性等)或外在因素(如時間覆蓋差異和空間覆蓋差異等)的差異,導致結構層面上通常是高度異質的,這種高度異質性為它們的對齊和協(xié)同解析帶來了巨大挑戰(zhàn)。大量研究發(fā)現人類在認知世界的過程中,聽覺、觸覺、嗅覺、視覺等多個模態(tài)的信息經過解析形成的概念最終是以語言為載體,且通過語言來進行關聯(lián)、推理、表達等思考行為。這表明,語言不僅精確編碼了我們對世界的感知和理解,還隱式地建立了各個模態(tài)中的聯(lián)系。盡管光學、紅外、高光譜、SAR、LiDAR等遙感數據存在內在機理或外在因素上的差異,但從語義角度來看它們都屬于對同一地物對象的不同視圖表達。因此,如果能夠將語言作為一個統(tǒng)一的參考框架,將這些不同模態(tài)的遙感數據通過模態(tài)專用編碼器映射到語言模態(tài),再在語言層面通過概念對齊實現多模態(tài)遙感數據的聯(lián)系與對齊,就可能克服它們之間的異質性,從而實現更加精確和精細的遙感地物目標理解。

5.2 視覺-語言聯(lián)合地物概念表達空間下的可解釋遙感影像智能理解范式構建

端到端的解譯方法(即將輸入圖像直接轉換成解譯結果)目前是遙感影像智能解譯的主流范式。然而,這種方法的推理過程缺乏透明度并且難以被外界理解,因此經常被詬病為“黑箱模型”。這一“黑箱”性質極大地增加了對模型預測結果置信度評估的難度,進而制約了遙感智能解譯技術在如國防安全、資源監(jiān)測等容錯率低的領域中應用。筆者認為真正的人工智能應該像人類一樣,能夠明確知道在不同條件下能做什么,不能做什么,并在可行的情況下提供一個可解釋的推理路徑,在不可行的情況下給出確切的原因。考慮到語言不僅是人類智能的顯著標志,也是思考和交流的基本工具,因此,探索如何指導模型在統(tǒng)一的語言空間中解析不同模態(tài)的數據,并以類似人類思考的方式整合不同模態(tài)和層次的視覺線索,完成視覺任務推理,將是未來一個極具吸引力和挑戰(zhàn)的研究方向。

5.3 視覺-語言聯(lián)合地物概念表達空間下的多類型遙感解譯任務耦合

聯(lián)合多個相關任務進行多任務學習達到任務間彼此促進的作用,已是計算機視覺研究領域的基本共識。大量研究也表明不同遙感解譯任務之間存在很強的層次相關性。但目前預訓練大模型向下游任務的遷移多是獨立進行的,這使得下游模型之間形成了信息孤島,無法有效地實現任務關聯(lián),從而限制了不同任務之間潛在的協(xié)同效應。眾多視覺心理學的研究揭示,人們在認知遙感影像時,往往不是簡單地完成單個視覺任務(如場景理解或目標識別),而是通過一種協(xié)同的認知機制,即首先提取對應不同視覺任務需要的視覺信息,然后在大腦中完成信息綜合,最后構建思維鏈完成復雜的影像認知。這種認知過程也得到了薩丕爾-沃爾夫假說[128]的支持。該假說強調語言在人類認知過程中的中心地位,即個體通過內在的語言機制組織思維并執(zhí)行推理,因此,能否在視覺-語言聯(lián)合地物概念表達空間下,構建一個以語言為核心的通用視覺任務接口,利用語言指令消除不同遙感視覺任務統(tǒng)一表達的鴻溝,以促進多類型遙感解譯任務的耦合和交互,將是一個極具吸引力和挑戰(zhàn)的研究方向。

5.4 視覺-語言聯(lián)合地物概念表達空間下的遙感地學知識提煉與挖掘

隨著遙感技術的飛速進步,能夠捕獲的地球表面多模態(tài)數據包括光學、紅外、高光譜、SAR和LiDAR等。這些數據中隱藏著豐富的地學信息,但挖掘這些信息的高效和精確方法仍是一個挑戰(zhàn)。未來研究的一個關鍵方向是探索如何利用大語言模型,將這些多樣化的遙感數據與人類的自然語言有效融合。在一個統(tǒng)一的語言空間內,這種整合不僅使不同來源和類型的遙感數據(包括遙感圖像、地理信息數據、歷史記錄等)描述和解釋地學現象變得更加自然,而且能夠幫助地學專家以更直觀、更精確的方式理解這些數據,進而推動新知識的產生。此外,模型能力的涌現在此過程中將可能發(fā)揮關鍵作用。這一過程涉及利用大語言模型自動從龐大的遙感數據集中探索和提煉新知識,揭示地球系統(tǒng)中之前未被發(fā)現或理解的模式和聯(lián)系。

6 結語

構建視覺模型以建立遙感影像數據與語義標簽間的映射關系是當前遙感智能解譯的核心范式。盡管這一范式在實踐中被廣泛應用,但它忽視了對遙感地物及其相互關系的深層次語義理解,導致在學習地物間復雜概念關系方面存在局限,進而極大限制了遙感解譯模型的應用潛力。

針對上述問題,本文以遙感地物概念表達為起點,深入分析了視覺與語言兩種模態(tài)數據在描述遙感地物概念中的獨特作用,即視覺模態(tài)擅長描述地物實體,而語言模擅長描述地物本體。基于這一認識,本文剖析了聯(lián)合視覺-語言兩種模態(tài)數據進行遙感地物概念表達的價值和意義,并討論了構建這一表達范式背后面臨的關鍵挑戰(zhàn)——模態(tài)對齊問題。在此基礎上,討論了這一范式如何催化遙感解譯模型新能力的涌現,并對這些新能力的產生原因和實際應用價值進行分析。最后,分別從視覺-語言聯(lián)合地物概念表達空間下的多模態(tài)遙感數據聯(lián)系與對齊、可解釋遙感影像智能理解范式構建、多類型遙感解譯任務耦合、遙感地學知識提煉與挖掘4個方面,對未來開展視覺-語言聯(lián)合的遙感地物概念表達與智能解譯研究的主要方向進行展望,以期為人工智能時代背景下定義并構建新一代遙感影像智能解譯框架提供視角。

京公網安備 11010802031220號

京公網安備 11010802031220號